第二章

人工智能的意识问题

作为有意识的存在会有什么感受?在你醒着的每个瞬间,又或者在梦境中,你会感觉到自己存在。当你欣赏最爱的音乐,或者细嗅早餐咖啡的香气时,你就在经历意识体验。目前的人工智能虽不能说具有意识,但随着它们越来越精巧,有没有可能它们也会感觉到自己存在?人工智能能否拥有感官体验,又能否感受到各种情感,例如炽烈的好奇或者刻骨的悲痛,又或者能否拥有与我们完全不同的体验?我们将这个问题称为 人工智能的意识问题 。无论未来人工智能发展有多惊人,如果机器无法拥有意识,即使它们能展现超群的智能,但却会缺少内在的精神世界。

对于生物而言,智能与意识似乎并肩同行。精巧的生物智能倾向于拥有复杂细腻的内在体验。但这一相关性对于非生物智能是否同样成立?许多人都这样认为,例如库兹韦尔等超人类主义者就倾向于认为,没有进行大脑增强的人类意识与超级人工智能的精神体验相比简直不值一提,正如人类意识就比老鼠丰富得多

。但我们之后会看到,这一思路并不完善。也许像《西部世界》(Westworld)中的多洛雷丝(Dolores)和《银翼杀手》(Blade Runner)中的雷切尔(Rachael)这样在机器之心中存有意识火花的特殊仿生人并不存在。即使人工智能在智力上超越了人类,我们也许仍然能在关键的维度上领先:我们能感受到自己的存在。

。但我们之后会看到,这一思路并不完善。也许像《西部世界》(Westworld)中的多洛雷丝(Dolores)和《银翼杀手》(Blade Runner)中的雷切尔(Rachael)这样在机器之心中存有意识火花的特殊仿生人并不存在。即使人工智能在智力上超越了人类,我们也许仍然能在关键的维度上领先:我们能感受到自己的存在。

我们先来简单看看意识多么令人费解,即使只考虑人类意识。

人工智能的意识,以及困难问题

哲学家戴维·查默斯(David Chalmers)提出了“意识的困难问题”:为什么大脑中所有这些信息处理会在大脑内部产生某种感受?为什么我们需要拥有意识体验?查默斯强调,这个问题似乎并不能纯粹用科学解答。比如说,我们即使发展出一套关于视觉的完整理论,理解大脑视觉处理的所有细节,也似乎无法理解为什么视觉系统的这些信息处理会带来主观体验。查默斯将困难问题与他所说的“简单问题”进行了对比,“简单问题”是总有一天可以用科学回答的那些关于意识的问题,例如注意力背后的机制,还有我们如何进行分类,又如何对刺激进行反应

。当然,这些科学问题本身都非常困难,而查默斯将它们称为“简单问题”是为了与意识的“困难问题”形成对比,他认为困难问题不能用科学解决。

。当然,这些科学问题本身都非常困难,而查默斯将它们称为“简单问题”是为了与意识的“困难问题”形成对比,他认为困难问题不能用科学解决。

我们现在面对的是另一个与意识相关的棘手难题,也可以说是机器意识的“困难问题”:

人工智能的意识问题 :人工智能的运转会不会在内部产生某种感受?

精巧的人工智能可以解决一些连最聪明的人类都束手无策的问题,但它的信息处理过程有没有某种能够被感受的特性?

人工智能的意识问题并非只是查默斯的困难问题在人工智能上的变体。实际上,这两个问题之间有一个关键的区别。查默斯的困难问题假定了我们具有意识,毕竟我们每个人内省一下就会发现自己拥有意识。问题在于为什么我们拥有意识。为什么大脑的某些信息处理过程会在内部产生某种感受?与之相反,人工智能的意识问题问的是,处于另一种载体上的人工智能,比如硅基人工智能,它们是否能够拥有意识。这个问题并没有提前假定人工智能拥有意识,毕竟这就是问题本身。这两个问题并不一样,但拥有一个共同点:也许它们都是单凭科学无法解决的问题

。

。

有关人工智能意识问题的讨论通常被两种针锋相对的立场所占据。第一种立场被称为

生物自然主义

(biological naturalism),它断言即使是最为精细的人工智能也不会拥有内在体验

。只有生物个体才能拥有意识,所以即使是最复杂的仿生人和超级智能都不会有意识。第二种立场更有影响力,我把它称为“对于人工智能意识的技术乐观主义”,简称“技术乐观主义”,它全盘否定了生物自然主义的想法。从认知科学的实证工作出发,技术乐观主义极力主张意识彻彻底底属于计算的范畴,所以复杂精妙的系统可以拥有内在体验。

。只有生物个体才能拥有意识,所以即使是最复杂的仿生人和超级智能都不会有意识。第二种立场更有影响力,我把它称为“对于人工智能意识的技术乐观主义”,简称“技术乐观主义”,它全盘否定了生物自然主义的想法。从认知科学的实证工作出发,技术乐观主义极力主张意识彻彻底底属于计算的范畴,所以复杂精妙的系统可以拥有内在体验。

生物自然主义

如果生物自然主义者正确的话,那么人与人工智能之间的爱情或者友谊都只能是纯粹的一厢情愿,即使是类似之前提到的电影《她》中的萨曼莎那样的人工智能也是如此。人工智能也许能比人类更聪明,甚至能够像萨曼莎那样表现出同情或爱意,但跟你的笔记本电脑相比,它并不会对世界有更多的体验。此外,不会有多少人希望与萨曼莎在云端相聚,因为将大脑上传到计算机就相当于放弃自己的意识。技术本身也许惊人,你也许可以将记忆准确地复制到云端,但这段数据流不等于你——它没有内在感受。

生物自然主义者认为,意识依赖于生物系统的特殊生化过程,依赖于某种肉体拥有但机器欠缺的性质或者特点。然而,这种性质从未被发现过,而即使它存在,这也不意味着人工智能无法拥有意识。也许会有另一些性质能向机器赋予意识。为了得知人工智能有没有意识,我们必须超脱特定载体的化学性质,转而在人工智能的行为中寻找线索,我在第四章将会详细解释这一点。

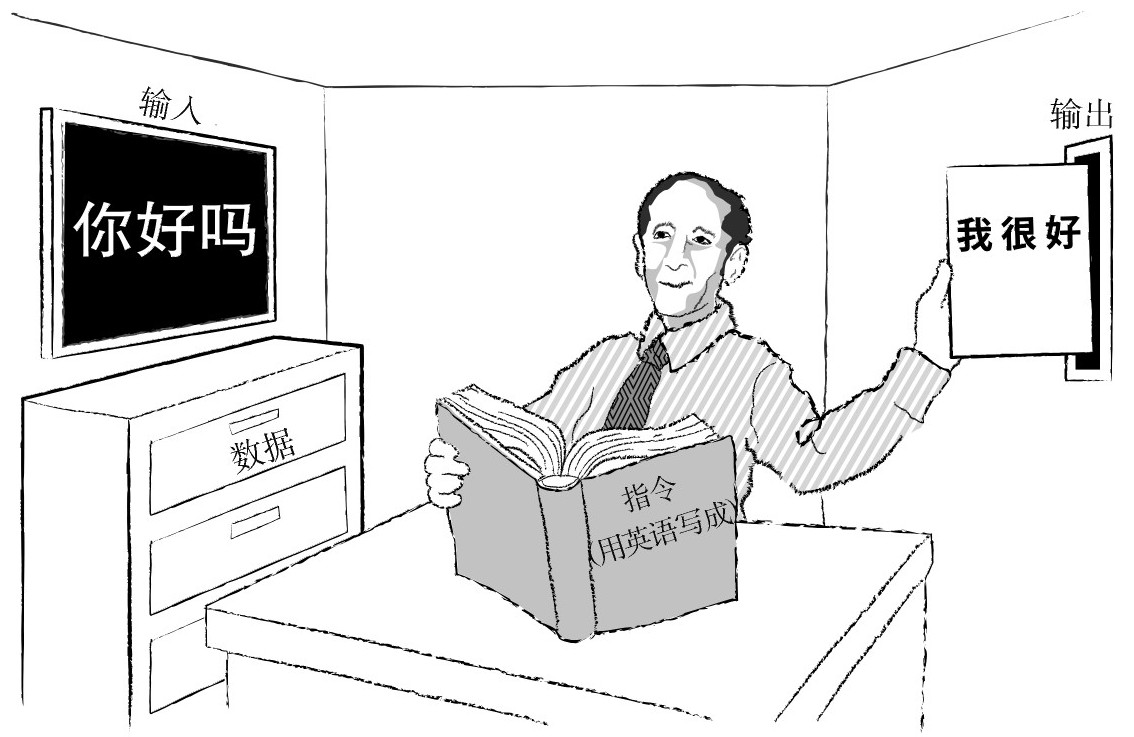

还有另一个更为巧妙而难以否定的论证思路。它来自哲学家约翰·瑟尔(John Searle)提出的一个著名思想实验,名为“中文屋”(Chinese Room)。瑟尔让我们想象他自己被锁在一个房间里,房间有一个开口,有人通过这个开口给他递送写着一串串汉字的卡片。虽然瑟尔本人不会中文,但在走进房间之前,他拿到了一本(用英文写的)规则手册,他可以在手册中查找特定的中文,然后抄下另外一串中文作为回答。瑟尔就这样走进房间,接受写着中文的卡片,根据手册写下一些汉字,然后将卡片放到墙上的另一个开口里

。

。

中文屋里的瑟尔

你可能会问:这跟人工智能有什么关系?我们注意到,对于房间外边的人来说,瑟尔的回应与会说中文的人一模一样。但瑟尔并不理解他写下来的东西是什么意思。他就像一台计算机那样,通过摆弄形式化的符号得出输入内容对应的答复。整个房间,再加上瑟尔和那些卡片,组成了某种信息处理系统,但瑟尔本人连半个汉字都不懂。那么,既然组成房间的这些元素没有一个能理解语言本身,那么它们是如何对数据进行操作,甚至能得到媲美实际理解或者内在体验的结果的?对于瑟尔来说,这个思想实验意味着,无论计算机看上去多么有智慧,它并不能真正思考或者理解,而只是在进行无意识的符号推演。

严格来说,这个思想实验尝试否定的是机器的理解能力,而不是机器中的意识。但瑟尔更进一步提出,如果计算机做不到理解,那么它也不可能拥有意识,尽管瑟尔没有一直强调他考虑的这一点。为了讨论,我们暂时认为瑟尔的说法是正确的,也就是理解与意识有着紧密联系。毕竟当我们理解事物时意识也同时存在,这也不是毫无可能。此外,在理解事物时我们不仅持有意识,更重要的是我们也基本处于某种觉醒和知晓的状态。

所以,瑟尔说中文屋不可能有意识,这对不对?许多批评者瞄准了论证中的关键一步:房间中摆弄符号的那个人不理解中文。对于批评者而言,关键不在于房间里有没有人懂中文,而是这个人加上卡片、手册、房间等

整体作为一个系统

是否理解中文。认为系统作为一个整体真正理解中文并具有意识的观点后来被称为“系统回应”

。

。

对我来说,系统回应在某种意义上正确,但在另一个意义上却是错的。它的正确之处在于,在考虑机器是否拥有意识时,真正的问题在于它作为一个整体是否拥有意识,而不是其中的部件如何。假设你端着一杯氤氲的绿茶,茶里的每个分子都不能说是透明的,但茶本身却是。透明是某些复杂系统的特性。同理,任何单个的神经元,甚至大脑的单个区域,都不会像整个人格或者个体那样能够实现某种复杂的意识。意识是高度复杂系统的特性,而不是像站在中文屋里的瑟尔那样,只是更大系统里的一个微型人

。

。

瑟尔推断整个系统不理解中文,因为站在里边的 他 不懂中文。换句话说,他认为因为系统的一 部分 没有意识,整个系统就没有意识。然而,这个思路有问题。整体拥有理解和意识,但其中一部分则不然的系统早已存在,那就是人脑。小脑拥有占整个人脑百分之八十的神经元,但我们知道它对于意识来说并非必需,因为有人生来没有小脑,但仍然拥有意识。我敢打赌小脑没有什么自我存在的感觉。

尽管如此,我认为系统回应在其中一点上有问题。它承认中文屋是一个有意识的系统,但像中文屋这样极端简化的系统不太可能拥有意识,因为拥有意识的系统要远远更复杂。比如说,人类大脑就拥有一千亿个神经元以及超过百万亿名为突触的神经连接(顺带一提,这个数字是银河系恒星数量的一千倍)。在人类大脑浩瀚的复杂度面前,甚至只是在老鼠大脑的复杂度面前,中文屋就像个小玩意儿。即使意识属于整个系统的性质,但并非所有系统都有这个性质。虽说如此,瑟尔的论证背后的逻辑有问题,因为他没能证明足够精巧的人工智能无法拥有意识。

总的来说,中文屋论证无法支撑生物自然主义。然而,尽管我们仍未找到足够有说服力的论证来 证明 生物自然主义,我们也没有什么一击必杀的论证来 否定 它。我在第三章将会说明,要辨明人造意识是否可能,目前为时尚早。但在说明之前,我们先考虑一下硬币的另一面。

对于机器意识的技术乐观主义

对于机器意识的技术乐观主义

(或者简称“技术乐观主义”)这个立场用一句话概括的话,那就是认为如果人类开发出足够先进的通用人工智能,那么它们肯定拥有意识。的确,这些人工智能也许可以体验到比人类更加丰富细腻的精神生活

。目前技术乐观主义人气正旺,尤其对于超人类主义者、某些人工智能专家和科技媒体来说。但与生物自然主义一样,我怀疑技术乐观主义目前还缺少足够的理论支持。尽管认知科学中对心智的某种看法似乎给这一观点提供了合理的动机,但实际并非如此。

。目前技术乐观主义人气正旺,尤其对于超人类主义者、某些人工智能专家和科技媒体来说。但与生物自然主义一样,我怀疑技术乐观主义目前还缺少足够的理论支持。尽管认知科学中对心智的某种看法似乎给这一观点提供了合理的动机,但实际并非如此。

技术乐观主义的灵感来自认知科学这个研究大脑的多学科交叉领域。认知科学研究者在大脑研究中作出的发现越多,人们就越觉得,从经验出发,最好的路线就是将大脑看作信息处理引擎,而所有精神功能都归于计算。计算主义(computationalism)现在已经成为了认知科学中某种类似研究范式的东西。这并不是说大脑的架构与普通计算机相同,事实并非如此。此外,大脑中具体的计算形式仍然是个有争议性的话题。但在今天,计算主义的影响越来越广泛,人们开始尝试利用算法来描述大脑及其部件。比如说,要描述某项认知或者感知能力,例如注意力或者工作记忆,我们可以将这一能力分解为互为因果作用的不同部分,其中每一部分都可以用对应的算法来描述

。

。

计算主义者侧重于用形式化的算法来解释精神功能,他们也倾向于认同机器能拥有意识,因为他们认为其他种类的载体上也能实现大脑中进行的那类运算。也就是说,他们倾向于支持思考的 载体独立性 (substrate independence)。

我们来解释一下这个术语。假设你正在筹划跨年派对,你知道有各种各样的办法来传达派对邀请的详细信息:面对面交谈、发短信、打电话等。我们能将关于派对时间和地点的实际信息与承载它的载体区分开来。同理,也许意识可以存在于不同的载体之上。至少在原则上,意识也许不仅能在生物大脑上实现,还能在利用基于其他载体(比如硅芯片)的系统上实现。这就叫“载体独立性”。

从这种观点出发,我们可以划定一种立场,我将其称为“意识计算主义”(Computationalism about Consciousness,简称CAC)。它的内容是:

意识可以用计算的角度来解释,此外,系统进行计算的具体细节确定了它是否拥有意识体验,以及意识体验的具体类别。

考虑一头宽吻海豚,它正在水中遨游,寻找小鱼果腹。对于计算主义者来说,这头海豚的内部计算状态决定了它意识体验的性质,包括水流掠过身体的感觉,还有猎物鲜美的味道。意识计算主义认为,如果(处于人造大脑内的)另一个系统S 2 也拥有完全相同的计算构造与状态,包括感觉系统接收的输入的话,那么它就跟海豚在同样的意义上拥有意识。为此,这一系统需要拥有海豚的所有内部心理状态,包括海豚在水中游动时的感觉体验。

这种系统精确模拟了另一个有意识系统的结构形式,我们把这样的系统称为

精确同构体

(precise isomorph),简称同构体

。如果某个人工智能拥有海豚所拥有的一切特性,那么意识计算主义预言这个人工智能会拥有意识。确实,这个人工智能将会拥有与原来系统完全相同的一切意识状态。

。如果某个人工智能拥有海豚所拥有的一切特性,那么意识计算主义预言这个人工智能会拥有意识。确实,这个人工智能将会拥有与原来系统完全相同的一切意识状态。

这听上去不错,但并没有证明对于人工智能意识的技术乐观主义是正确的。对于我们很有可能建造出来的人工智能是否会拥有意识的问题,意识计算主义的论述少得惊人——它只是表明,如果我们能够建造生物大脑的同构体,那么它就会拥有意识。对于并非生物大脑同构体的系统如何,意识计算主义保持着沉默。

总的来说,意识计算主义在原则上认可了机器意识的可能性: 如果 我们能够创造一个精确同构体,那么它就会拥有意识。但即使在原则上某种技术可能被创造出来,这也不意味着它实际上会出现。比如说,你可能会认为能穿越虫洞的宇宙飞船在概念上可行,其中不包含任何矛盾(虽然围绕这一点尚有争论),然而它的实际建造也许会违反物理定律。可能不存在任何方法能够产生足够的特殊能量来稳定虫洞,又或者这样做虽然不违背自然法则,但地球上的人类永远不会拥有为此所需的技术水平。

对于机器意识,哲学家会将逻辑或者概念上的可能性与其他类型的可能性区分开来。如果某项事物拥有符合法则的可能性(又称为律则可能性),那么这相当于要求它的建造与自然法则相容。在符合法则的可能性范畴之内,区分某项事物的 技术可能性 又有着进一步的意义。技术可能性是说,除了要求事物拥有符合法则的可能性以外,还要求人类在技术上能够将它作为人造物制造出来。尽管探讨人工智能意识的概念可能性这个更宽泛的话题显然很重要,但我要强调的是,我们以后可能制造出来的人工智能是否可能拥有意识这一点在实践中也非常重要。因此,我特别感兴趣的是机器意识的技术可能性,还有实际的开发项目会不会尝试去建造这样拥有意识的机器。

为了探索这些可能性,我们先来考虑下面这个广为人知的思想实验,其中涉及如何创造同构体。而你作为读者将会是这一实验的参与者。这一创造过程会保留你的所有精神功能,但这仍然属于某种增强,因为它将这些功能转移到了另一种更为耐用的载体。现在就开始吧。

大脑活性恢复疗法

现在是2060年,你的思维仍然敏捷,但你还是决定预先做个治疗,恢复大脑的活性。你的朋友之前一直跟你说可以试试心雕(Mind-sculpt)公司,他们会在一个小时内慢慢地将大脑的每个部分换成芯片,最后你得到的就是完全人工的大脑。你坐在等待室,不安地等待着这一手术的问诊咨询,毕竟你也不是每天都在考虑将大脑换成芯片。轮到你见医生了,你问道:“手术之后这真的还是我吗?”

医生信心十足地向你解释:你的意识来自大脑的 精确功能结构 ,也就是大脑不同构成部分之间相互影响作用的抽象模式。她还说,新的大脑成像技术能够建立你的个性化“心智图谱”,也就是描绘了你的心智如何运转的图谱,它完全确定了你的各种精神状态互相影响的每一种可能性,以及这会如何决定你产生的情绪、你做出的行为、你感知到的事物,如此等等。在描述的过程中,这位医生明显惊叹于这一技术的精确性。最后,她看了看表,做出总结:“所以说,虽然你的大脑会被芯片代替,但心智图谱并不会改变。”

你松了一口气,于是就预约了手术。在手术过程中,医生要求你保持清醒并回答她的问题。然后她开始移除一组组神经元,并用硅基的人造神经元代替它们。她从听觉皮层开始替换神经元,而在这一过程中,她时不时问你觉不觉得对她声音的感受有什么不同。你的答案是没什么不同,于是她接下来处理视觉皮层。你告诉她你的视觉体验似乎没有改变,于是她就继续手术。

不知不觉,手术就完成了。“恭喜你!”她热烈祝贺着你,“你现在就属于一种特殊的人工智能了,你拥有一个从原来生物大脑复制而来的人工大脑。在医疗界我们把你叫做一个‘同构体’。”

这意味着什么?

哲学思想实验的目的是引发想象,是否赞同故事的结尾是你的自由。在这个思想实验中,手术取得了成功,但你是真的跟之前有着完全相同的感受,还是会觉得有些异样?

你的第一反应可能是疑惑,手术结束后的那个人到底是你本人,还是某种复制品。这是个重要的问题,也是第五章的重要主题。现在我们先假设手术结束后的那个人还是你自己,将精力集中到另一个问题:意识的感受会不会改变。

在《有意识的心灵》(The Conscious Mind)一书中,哲学家戴维·查默斯讨论了类似的案例,他主张你的个人体验会保持不变,因为其他假设实在过分牵强。

其中一种替代假设认为,在神经元被替换的过程中,你的意识会逐渐弱化,就像音乐播放器的音量逐渐被调低。另一个假设则认为,你的意识会维持不变,直到在某个时间点突然中断。这两种情况的结果都一样:意识如灯灭。

其中一种替代假设认为,在神经元被替换的过程中,你的意识会逐渐弱化,就像音乐播放器的音量逐渐被调低。另一个假设则认为,你的意识会维持不变,直到在某个时间点突然中断。这两种情况的结果都一样:意识如灯灭。

我和查默斯都认为这两种情景非常不可能发生。如果承认思想实验的前提,这些人工神经元的确精确复制了所有功能,那么很难想象它们怎么会导致你的意识逐渐暗淡或者突然消失。根据定义,这样的人工神经元作为复制品,与决定你心理活动的神经元有着完全一致的因果属性。

所以,更有可能发生的是,这一过程完成之后创造出来的是一个拥有意识的人工智能。这一思想实验说明了机械意识至少在概念上可行。但我们在第一章已经注意到,像这种思想实验导出的概念上的可能性,并不能保证当我们这个物种创造出精巧的人工智能时,这些人工智能会拥有意识。

还有一个很重要的问题,就是这个思想实验中描绘的情景是不是真的会发生。同构体的建造是否与自然法则相容?即使相容,人类是否终有一天能够拥有足够的技术能力?到时候他们又想不想去建造它?

要谈论这个思想实验在自然法则之内是否可行(或者说律则可能性)这个问题,我们要考虑到目前还不知道其他种类的材料能否再现你心理活动能被感知的性质。但也许不久之后,医生就会开始将基于人工智能的医疗植入物放入大脑中支撑意识体验的区域,到时候我们就会知道了。

担心这种替代并不可能的原因之一,就是意识体验可能依靠大脑的量子力学特性。如果的确如此,那么我们可能永远都不能依靠科学从你的大脑中获得必需的信息,用于构建在量子意义上你的一个真正的复制品,因为量子力学对粒子测量的限制也许并不允许我们从你的大脑中获得用于构建你的真正同构体所需的精确信息。

但为了能继续进行讨论,我们先假定同构体的产生无论在概念上还是在自然法则上都是可行的。那么,人类会制造同构体吗?我很怀疑,因为要让某个生物学上的人类逐步增强大脑,最后成为完整的人工同构体,这需要的技术发展远远超出了少数几个神经假体的范围。同构体的开发需要科学进展到能够利用人工部件替换大脑所有部分的程度。

此外,接下来数十年的医学进展很可能并不包括能够完全复制一组神经元计算功能的大脑植入物,而刚才的思想实验要求大脑的所有区域都能用精确的复制品来代替。而且,当技术进展到这个地步,人们更可能倾向于利用这类手术进行大脑增强,而不是仅仅成为此前自我的同构体

。

。

即使人们自我设限,只希望复制而不是增强自己的能力,但神经科学家又如何做到这一点呢?这些研究者需要完全了解大脑如何运作。我们之前已经看到,程序员需要确定所有与系统信息处理有密切关联的抽象特性,而不是依赖于与计算无关的低层次特性。在这里,要判断特性是否相关并非易事。大脑中的激素与计算有关吗?神经胶质细胞呢?此外,即使获得了这类信息,要运行一个精确细致地模拟大脑的程序也需要极为庞大的计算资源——我们数十年后也不一定能拥有的计算资源。

会不会有某种商业上的必要性,必须通过同构体来制造更精巧的人工智能呢?我很怀疑。我们没有理由相信让机器完成一系列任务的最经济有效的方法就是对大脑进行细致的反向工程。比如说,我们考虑目前作为围棋、国际象棋或者《危险边缘》世界冠军的那些人工智能。在每一个案例中,这些人工智能都超越了人类,但它们利用的技巧与人类玩这些游戏时用到的截然不同。

回想一下我们一开始为什么提出同构体可行性的问题。它的答案会告诉我们机器是否可能拥有意识。但对于我们在未来会实际开发的机器是否会有意识这个问题来说,同构体只是一种干扰。远在我们能够建造同构体之前,人工智能就会到达一个非常高的水平。我们需要先回答这个问题,尤其是考虑到我之前提出的关于人工智能在伦理和安全方面那些担忧的话。

所以从本质上来说,技术乐观主义者关于人造意识的那种乐观所依靠的论证思路有问题。这些人对于机器能够拥有意识非常乐观,因为我们知道大脑拥有意识,而我们能够建造它的同构体。但其实我们不知道这是否可行,又或者我们愿不愿意这样做。这是一个需要实践来回答的问题,而我们实际上走这条路径的可能性并不大。此外,它的答案跟我们真正想要知道的东西关系不大,我们想要知道的是其他人工智能系统——那些并非在致力建造大脑同构体的尝试中出现的人工智能——它们是否拥有意识。

强大的自动化系统在进一步演变之后能否拥有意识,又会不会拥有意识,这个问题至关重要。要记住,意识可能会在整体上对机器的伦理行为产生各种不同的影响,这依赖于系统架构中的细节。在某些类型的人工智能系统中,意识可能会使机器的行为更为反复无常,而在别的类型中,意识可能会令人工智能更富有同情心。即使在单一系统中,对于不同的关键系统特征,例如智力、共情能力、目标保真等,意识也可能产生不同的影响。当前研究应当谈及相关的每一种可能的结果。例如,早期的测试和警觉也许能营造某种有益的环境,用以实现“人工实践美德”,也就是人类通过刻意培养的方式让机器学习伦理原则,藉此“养育”拥有道德导向的机器。对于重要的人工智能,我们应该先在受控封闭环境中搜寻它拥有意识的迹象。如果它有意识,那么我们应当研究意识对于这台特定机器的架构有何影响。

要回答这些亟待解决的问题,我们先把关于神经元的精确置换这类作为玩具模型的思想实验放到一边,无论它们多么有趣。尽管这些思想实验做出了重大的贡献,帮助我们思考拥有意识的人工智能有没有概念上的可行性,但我已经指出,关于我们最终会不会造出拥有意识的人工智能,以及这些系统具体性质的问题,这些思想实验并没有带来多少教益。

我们会在第三章继续讨论这些问题。在这一章中,我会脱离常规的哲学争辩,采取另一种方式来探索如下的问题:给定自然规律与人类技术能力的预期,我们能否创造带有意识的人工智能?技术乐观主义者认为这是肯定的,而生物自然主义者却是全盘否定。我强烈认为,实际的情况要远远复杂得多。